OpenAI 把大招放出来了!GPT-OSS 开源:120B 巨兽 + 20B 轻量版,128K 长文一口气读完,还直接 Apache 2.0 任你魔改

温馨提示:本文可能让显卡贩子连夜涨价,也让闭源厂商连夜开会。请自备钱包和速效救心丸。

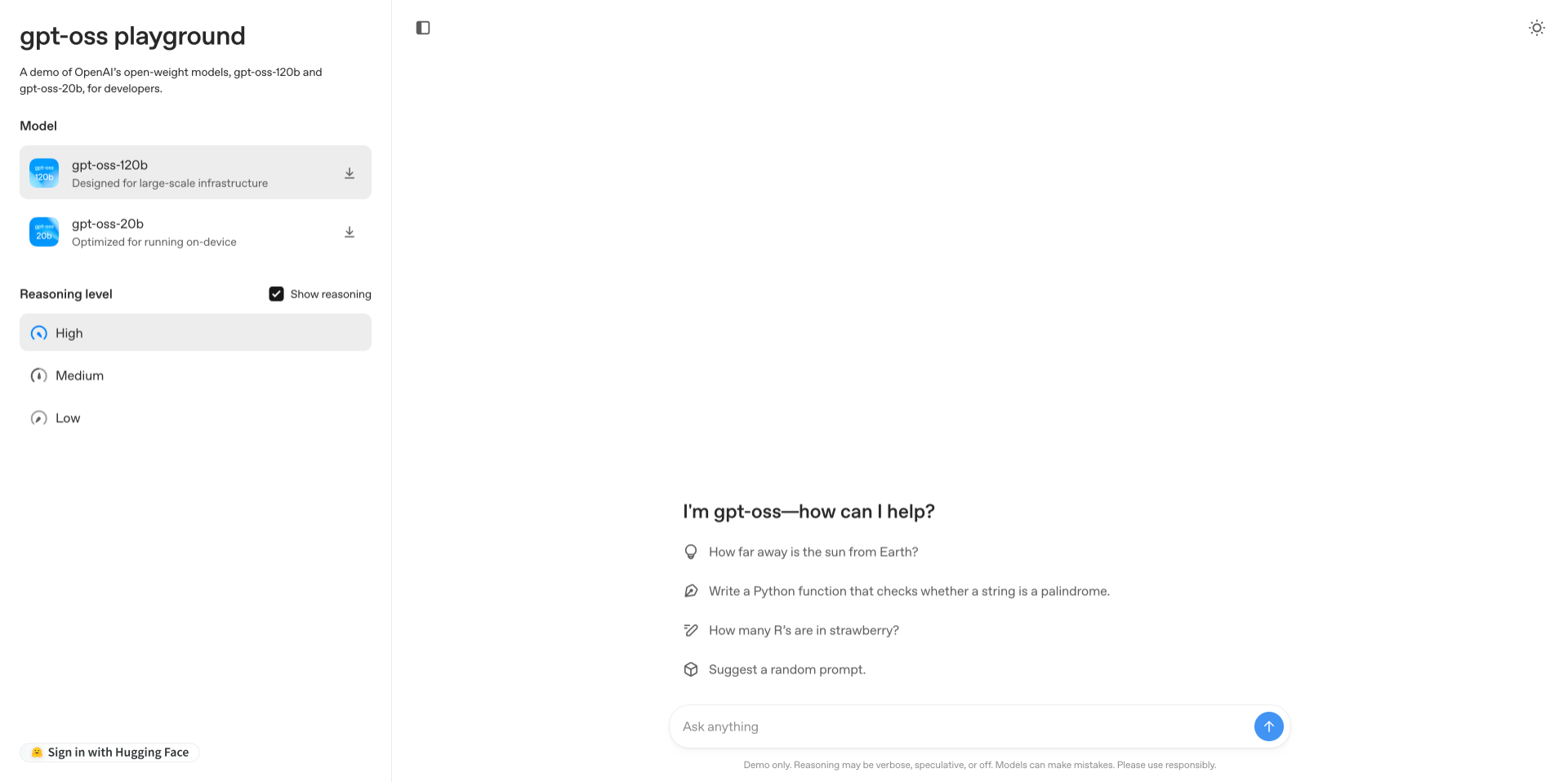

一、GPT-OSS 是啥?

一句话:OpenAI 自 2019 年 GPT-2 之后,首次把官方权重 拿出来给大家白嫖。

两个版本:

– GPT-OSS-120B:大力出奇迹,128K 上下文,一口气吞下一本《三体》三部曲。

– GPT-OSS-20B:16 GB 内存就能跑,笔记本也能当本地 AI 助手。

二、核心亮点,一张表看懂

| 亮点 | 人话解释 | 典型场景 |

|---|---|---|

| 128K 超长上下文 | 把整份合同 / 论文 / 财报塞进去,模型不喘 | 律师、审计、科研狗狂喜 |

| MoE 架构 | 专家分工,省显存、省电费、省房租 | 中小企业也能玩 120B |

| Apache 2.0 真·开源 | 下载、微调、商用、卖钱,通通 OK | 闭源厂商哭晕在厕所 |

| Agent 全家桶 | 函数调用、结构化输出、Python 执行、Web 浏览,一条龙 | 本地 AI 助理 / 自动化脚本神器 |

三、性能八卦

- GPT-OSS-120B 在 MMLU、HumanEval、HealthBench 上逼近 o4-mini(GPT-4-mini),官方盖章“接近闭源性能”。

- GPT-OSS-20B 在 16 GB 机器上跑,QPS 吊打同量级模型,堪称“贫穷限制不了我的想象力”。

四、三步白嫖指南

- 下载权重

– Hugging Face 搜openai/gpt-oss-120b或openai/gpt-oss-20b

– 点一下“Download”,几百 GB 的流量说没就没。 - 本地部署

– 20B:RTX 4090 单卡即可;120B:多卡 or 云端 A100。

– 官方脚本开箱即用,支持 Transformers + vLLM + llama.cpp。 - 在线先尝后买

– 暂不支持网页 Demo,但社区已火速放出 Colab 懒人包,搜索“GPT-OSS Colab”即可零成本试玩。

五、彩蛋 & 吐槽

- 学生党:毕业论文 10 万字直接扔进去,摘要自动生成,查重率还低。

- 创业者:把 120B 微调完卖 SaaS,成本只要电费,VC 看了直呼内行。

- 闭源厂商:连夜发公告“我们也有长上下文”,结果一看还是 32K。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...